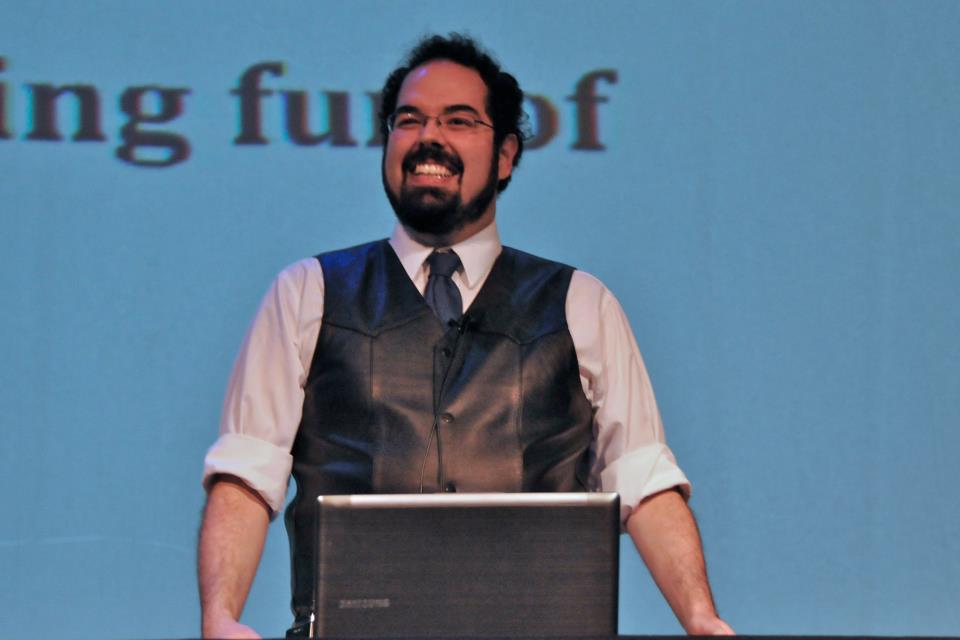

Otvoreno pismo koje je niz osoba iz tehnološkog svijeta, uključujući Elona Muska i Stevea Wozniaka, objavilo priuje desetak dana, zahtijevajući šestomjesečnu pauzu u razvoju novih umjetnih inteligencija dok se ne razviju sigurnosni protokoli, izazvalo je široku raspravu. U raspravu se uključio i Eliezer Yudkowsky kojeg smatraju jednim od vodećih stručnjaka za umjetnu inteligenciju, polje koje istražuje više od 20 godina, kroz članak objavljen u časopisu Time.

Istraživač umjetne inteligencije i etike objašnjava razloge zašto nije potpisao pismo i izlaže svoju viziju onoga šta možemo pronaći ako se dosegne Opća umjetna inteligencija u trenutnim okolnostima i šta moramo učiniti kako bismo spriječili da "sav biološki život na Zemlji izumre ubrzo nakon toga".

Yudkowsky je suosnivač Instituta za istraživanje strojne inteligencije MIRI 2000. godine i jedan je od pionira i predvodnika u području prijateljske umjetne inteligencije. To je ideja da umjetna inteligencija treba biti dizajnirana tako da bude kompatibilna s ljudskim vrijednostima i ciljevima.

U svom članku cijeni zahtjev za šestomjesečnim prekidom rada "jer je to bolje nego da ga nema", ali smatra da potpisnici potcjenjuju ozbiljnost situacije i "traže premalo da se riješi". Smatra da se sav razvoj umjetne inteligencije koji se provodi mora prekinuti, na neodređeno vrijeme i u cijelom svijetu, sve dok ne bude moguće sigurno razviti ovu vrstu sistema.

Musk i ostali potpisnici istaknuli su svoju zabrinutost da alati umjetne inteligencije dosežu razinu na kojoj su "konkurentni s ljudima". Za Yudkowskog problem nije u tome, već u tome što će doći kada se postigne umjetna inteligencija bolja od prirodne ljudske.

“Ključni pragovi [do kojih treba doći] možda nisu očiti. Definitivno ne možemo unaprijed izračunati šta će se dogoditi i kada, a trenutno je zamislivo da bi istraživačka laboratorija mogla nenamjerno preći kritične granice”, objašnjava.

Nije problem, nastavlja dalje, "načelno" nerješiv. Ova vrsta perspektive života ima vrijednost i mogla bi se ugraditi u sustave umjetne inteligencije, ali problem je u tome što "nismo spremni i ne znamo kako to učiniti". Bez ovog pristupa, umjetna inteligencija bi nas vidjela kao resurse za svoje svrhe. To bi bila umjetna inteligencija “koja vas niti voli niti mrzi, vi ste napravljeni od atoma koje može koristiti za nešto drugo”.

Za Yudkowskog bi rezultat suočavanja čovječanstva s višom inteligencijom bio katastrofalan. Baš kao “11. stoljeće u borbi protiv 21. stoljeća ili australopitek koji pokušava nadmašiti homo sapiensa”. On zamišlja neprijateljsku umjetnu inteligenciju koja je bolja od ljudske kao "potpuno vanzemaljsku civilizaciju, koja razmišlja brzinom milionima puta većom od ljudske, u početku ograničenu na računare", nešto što se neće dugo zadržati.

Istraživač kritizira da OpenAI, programer ChatGPT-a koji trenutno obučava svoj sljedeći jezični model, GPT-5, planira "imati neku buduću umjetnu inteligenciju za zadatak usklađivanja AI-ja". Ovo usklađivanje je mjera do koje se ciljevi i radnje sistema umjetne inteligencije podudaraju sa ciljevima i interesima njegovih dizajnera ili korisnika. Odnosno, da umjetna inteligencija radi ono što mi želimo, a ne ono što mi ne želimo da radi.

Yudkowsky preporučuje potpuno zaustavljanje obuke AI-a u svim zemljama dok se ne postigne dovoljna sigurnost, gašenje GPU računarskih centara koje koriste, praćenje GPU-ova koji se prodaju kako bi se spriječila zemlja da ih izgradi, stavljanje ograničenja na računsku snagu koja se može koristiti za obučavanje AI i rezerviranje za vrlo specifična polja i bez povezivanja s internetom.

“Nismo spremni. Nismo na putu da budemo znatno spremniji u doglednoj budućnosti. Ako prođemo kroz ovo, svi će umrijeti, uključujući i djecu koja ovo nisu izabrala i nisu učinila ništa loše. Isključite sve”, zaključuje Yudkowsky.